Pour faire marcher un assistant intelligent, il faut 2 choses:

- un moteur

- un modèle de connaissances

Le moteur c’est GPT (en gros!)

Oui, le même GPT que dans ChatGPT…

GPT c’est Generative Pre-trained Transformer en anglais…

Il y a :

- ChatGPT de OpenAI https://chatgpt.com/

- Gemini de Google https://gemini.google.com/app

- Claude de Anthropic https://claude.ai/new

- Groq de Groq https://console.groq.com/playground

- Lambda Chat de CloudNative https://lambda.chat/chatui/

- Perplexity de Perplexity https://www.perplexity.ai/

- …

et des agrégateurs comme :

- HuggingChat de HuggingFace https://huggingface.co/chat/

- ChatHub de ChatHub https://app.chathub.gg/

- …

Nous avons un très bon chat local sur Montpellier qui fait aussi du code : ISDM Chat https://isdm-chat.crocc.meso.umontpellier.fr/

Le modèle de connaissances LLM que fait tourner le moteur

LLM c’est Large Language Model …

Le modèle c’est le résultat d’un apprentissage qui ingère des milliards de données et qui les stocke sous forme de vecteurs….

Certaines fois, le moteur et le modèle sont intégrés, comme ChatGPT…

D’autres fois il faut télécharger ou bien sélectionner le modèle qu’on souhaite…notamment avec les agrégateurs.

Les modèles connus sont par exemple:

- GPT-4o de chatgpt

- Claude 3.5 Sonnet de claude

- Gemini 1.5 pro de google

- Llama 3.1 de meta

- Mistral 8x de mistral

- Gemma 2 de qui?

- Qwen 2 de qui?

- Perplexity Sona de Perplexity

- Phi-3 de microsoft

- LlaVa de qui?

- …

A chaque modèle vous verrez aussi accolé au nom un code qui finit par B comme 7B, 13B, 70B ou encore 405B…

Il s’agit de la taille du modèle exprimée en milliards de vecteurs…

Plus il y en a et plus le modèle est capable de donner des réponses de qualité….

Mais alors pourquoi ne pas utiliser toujours un 405B et jeter les plus petits ??

Ma bonne dame, plus le modèle est gros et plus il faut de mémoire RAM à votre ordinateur!

Par exemple un PC avec 16GO de RAM peut faire tourner un LLM 7B ou 8B.

Il faut ensuite passer à 32 GO de RAM pour espérer utiliser du 13B mais pas du 70B …

Moi je veux faire ça chez moi, sans que mes concurrents ou les GAFAM le sachent…

OUI, c’est possible!

Vous pouvez télécharger un GPT gratuit et lui adjoindre un LLM open source…

Bon si vous avez juste 16GO de RAM, ce sera juste un 7B ou 8B….

J’ai testé pour vous:

- GPT4All : https://www.nomic.ai/gpt4all

- je le recommande chaudement car

- on peut l’installer sans droits Admin (hein!)

- on peut télécharger les modèles :

- Llama 3.1 8B

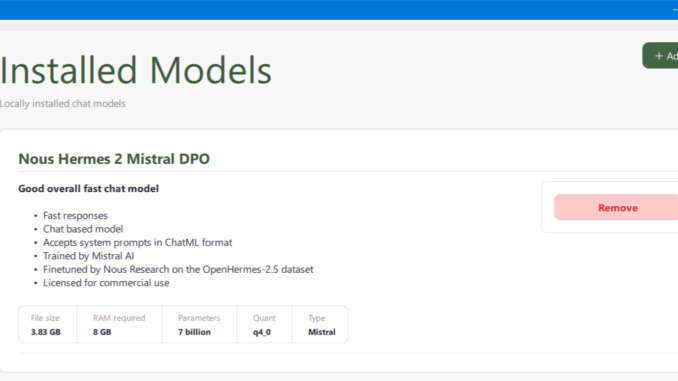

- Nous Hermes 2 Mistral

- on peut lui donner un répertoire avec ses propres documents à intégrer dans les prompts (RAG)

- au final il est pas rapide comme chatgpt mais c’est correct

- LM Studio : https://lmstudio.ai/

- moins facile:

- il faut les droits Admin pour l’installer

- on ne peut pas ajouter ses propres documents

- il est aussi rapide que GPT4All

- on peut télécharger des modèles :

- Llama 3.1 8B

- AnythingLLM : https://anythingllm.com/

- là j’ai mis 2 jours à le faire fonctionner / une UX euh…

- mais il y a un modèle plus rare : LlaVa 8B mutimode texte et images

- et aussi CodeLlama 7B spécialisé en programmation (pas encore testé)

Alors avec tout ça, t’en penses quoi?

ChatGPT est rapide et présente bien.

Gemini est très rapide et fournit des réponses plus précises et plus documentées que ChatGPT. En plus il peut aller chercher sur le Web…Et c’est gratos…

Perplexity est super à la place du moteur de recherche de Google.

Le reste ça se vaut à partir du moment où tu utilises le même modèle Llama 3.1 8B …

En local je recommande GPT4All pour sa facilité et son RAG.

Le RAG, KESAKO?

RAG c’est pour « retrieval augmented generation« , en français : génération augmentée de récupération !!

Bref, c’est la possibilité d’ajouter des documents à un moteur pour compléter les connaissances du LLM…

Vous allez en entendre parler, forcément.